分享一段非常简单的Python批量采集wordpress网站数据的爬虫脚本,实现采集wordpress程序的网站的整站数据的爬虫程序。从首页开始,抓取href标签,到子页面后还是要继续找href标签,采用Python递归方法,直接贴代码吧!

import reimport bs4import urllib.request url_home = 'https://www.56admin.com/' #要采集的网站url_pattern = url_home + '([\s\S]*)\.html' #正则表达式匹配文章页面,此处需完善为更好的写法url_set = set()url_cache = set()url_count = 0url_maxCount = 1000 #最大采集数量 #采集匹配文章内容的href标签def spiderURL(url, pattern): html = urllib.request.urlopen(url).read().decode('utf8') soup = bs4.BeautifulSoup(html, 'html.parser') links = soup.find_all('a', href = re.compile(pattern)) for link in links: if link['href'] not in url_cache: url_set.add(link['href']) return soup #采集的过程 异常处理还需要完善,对于一些加了防采集的站,还需要处理header的,下次我们再学习spiderURL(url_home, url_pattern) while len(url_set) != 0: try: url = url_set.pop() url_cache.add(url) soup = spiderURL(url, url_pattern) page = soup.find('div', {'class':'content'}) title = page.find('h1').get_text() autor = page.find('h4').get_text() content = page.find('article').get_text() print(title, autor, url) except Exception as e: print(url, e) continue else: url_count += 1 finally: if url_count == url_maxCount: break print('一共采集了: ' + str(url_count) + ' 条数据')

你可能想看:

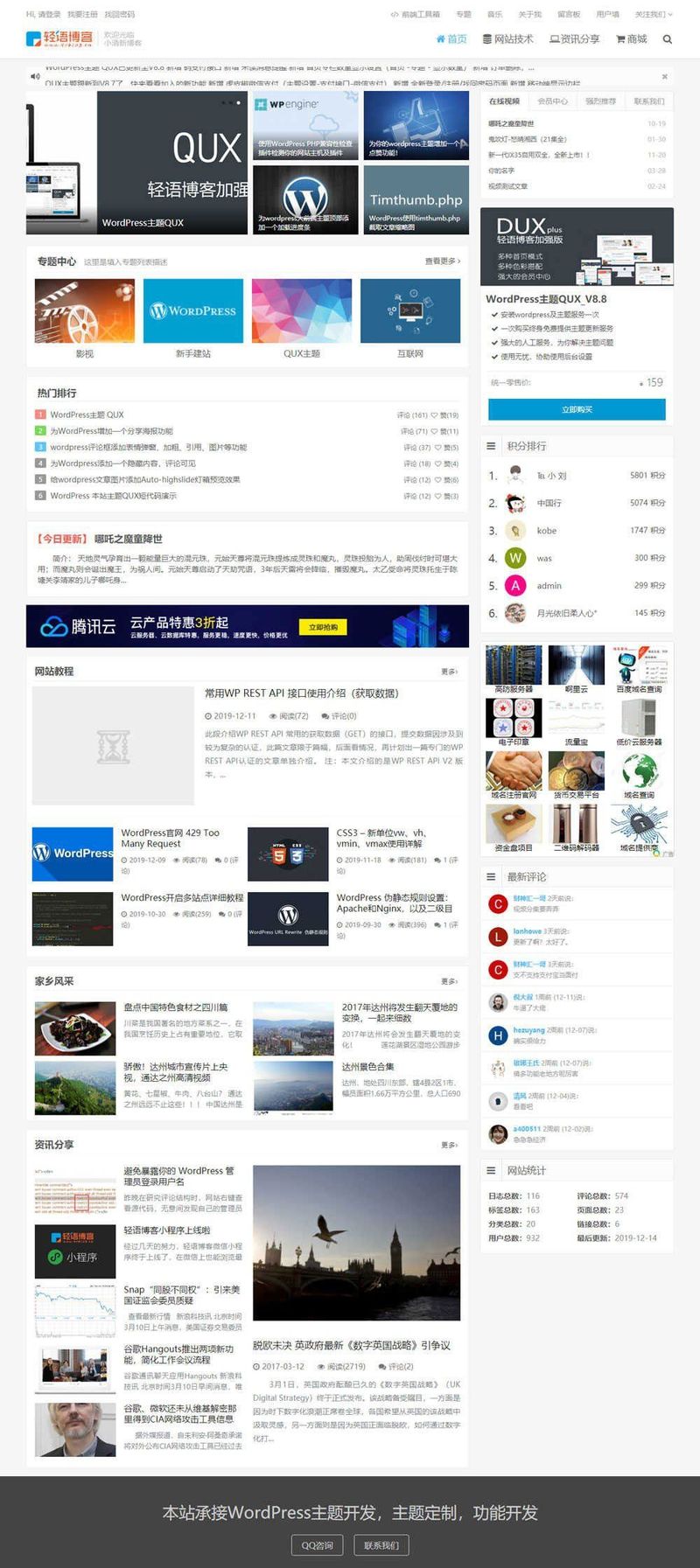

![WordPress主题 DUX 小清新CMS主题带用户中心模板[更新至v3.0]](https://www.56admin.com/wp-content/uploads/2018/01/2018012603423610.png)

![[wordpress模板] 强大SNS轻社交/论坛wordpress主题:LightSNS-1.3正式版](https://ws1.sinaimg.cn/large/69bd00e3ly1fwd9utltmmj20ku1vtdnw.jpg)

琼ICP备20002778号

琼ICP备20002778号

发表评论

共有[ 6 ]人发表了评论